Das Problem, Google Play Store aktualisiert Apps nicht oder downloaden (heruntergeladen) werden, ist ein häufiges Problem bei ADSL-Internetdiensten. In diesem Text stellen wir Ihnen acht Methoden zur Lösung dieses Problems, wenn Sie den ADSL-Internetdienst oder andere ISPs verwenden.

Bleib bei uns…

Eine Einführung über das Problem, dass Apps in Google Play Store in Android nicht aktualisiert oder downloaden werden

Dies ist der offizielle Store zum Installieren und Aktualisieren von Apps und Spiele in Android. Eines der häufigsten Probleme von Android-Handys ist, dass die Apps möglicherweise nicht im google play downloaden oder aktualisiert werden. Dieses Problem tritt am häufigsten auf, wenn Sie Internet ADSL und andere ISPs verwenden. Bei der Installation von Apps im Store können folgende Probleme auftreten:

- Der Play Store nicht geöffnet werden.

- Apps im dies nicht aktualisiert werden.

- Die Apps nicht mehr im Play Store heruntergeladen.

- Das Herunterladen des Programms stoppt bei 99%.

So beheben Sie das Problem, dass die Apps im Google Play Store nicht downloaden oder aktualisiert wird

1- Neustart

Bevor Sie etwas tun, ist es besser, das Telefon einmal neu zu starten. Die Probleme können behoben werden.

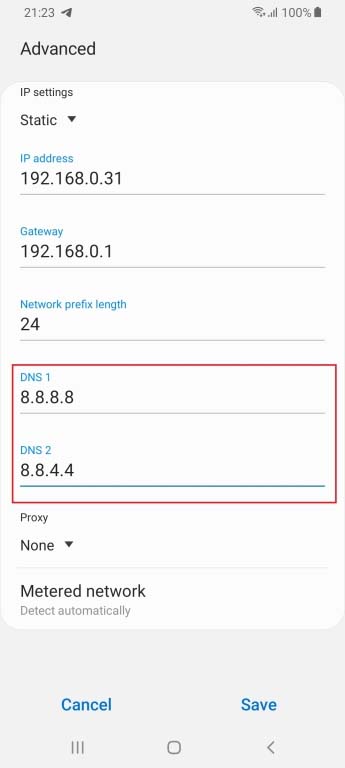

2- Android Wi-Fi DNS ändern

Dieses Problem besteht im Telekommunikations-Internet, mit dem wir über WLAN verbunden sind. Daher können wir dieses Problem lösen, indem wir den DNS von Wi-Fi ändern. Für diesen Zweck:

- Öffne die Einstellungen auf dem Gerät.

- Gehe zu den “Connections”.

- Gehe zum Abschnitt “Wi-Fi”.

- Tippen Sie auf das verbundene WLAN(Wi-Fi).

- Wähle “Erweitert”.

- Tippe in den IP-Einstellungen auf Statisch.

- Gebe dann DNS 1 und DNS 2 wie unten gezeigt ein:

- Tippe anschließend auf Speichern.

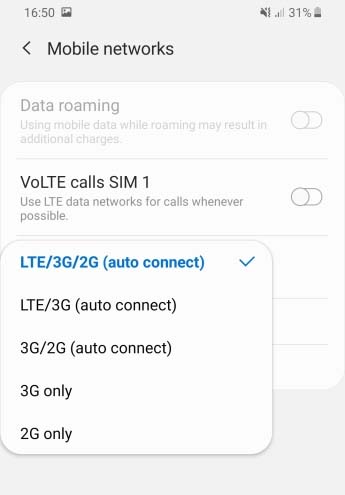

3- Ändern Sie das Mobilfunknetz, um dieses Problem zu beheben

Wenn Sie dieses Problem, ist es besser, das Netzwerk auf 3G oder 4G zu ändern. Dann wird Ihre IP geändert und das Problem behoben (Mobilfunknetz ändern).

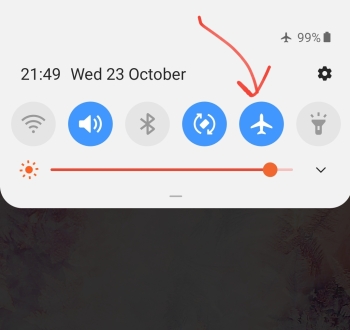

4- Schalten Sie den Flugzeugmodus ein

Sie können überrascht sein. Der Flugzeugmodus kann dieses Problem jedoch beheben. Wenn Sie Wi-Fi verwenden, versetzen Sie Ihr Telefon mithilfe des „Lernprogramms zur Aktivierung des Flugzeugmodus“ in den Flugzeugmodus und besuchen Sie den Google Play.

5- VPN-Deaktivierung

Wenn Sie auf Ihrem Telefon VPN oder Proxy verwenden, stellen Sie sicher, dass die App-Leistung dadurch beeinträchtigt wurde. Schalten Sie also den Proxy aus und versuchen Sie dann, die Apps herunterzuladen und zu aktualisieren.

Es sollte beachtet werden, dass es aufgrund von Sanktionen hilfreich sein kann, Proxy oder VPN zu verwenden, wenn ein Problem auftritt.

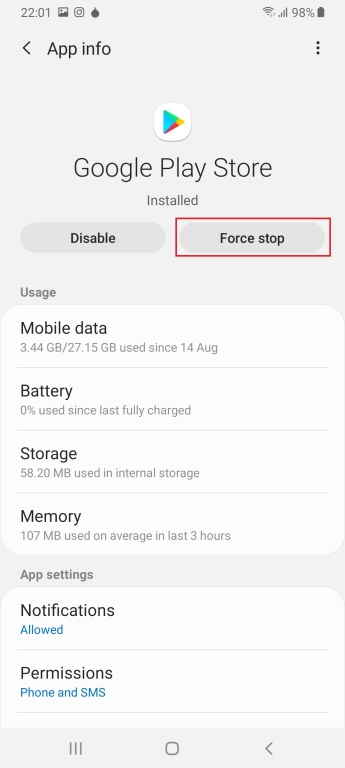

6- „Stopp erzwingen“ das Programm (Kraft anhalten)

- Öffnen Sie die “Einstellungen” auf dem Android-Gerät.

- Blättern Sie durch die Liste und tippen Sie auf “Apps”.

- Blättern Sie durch die Liste, um den “Google Play Store” zu finden.

- Tippen Sie auf “FORCE STOP” (Stopp erzwingen).

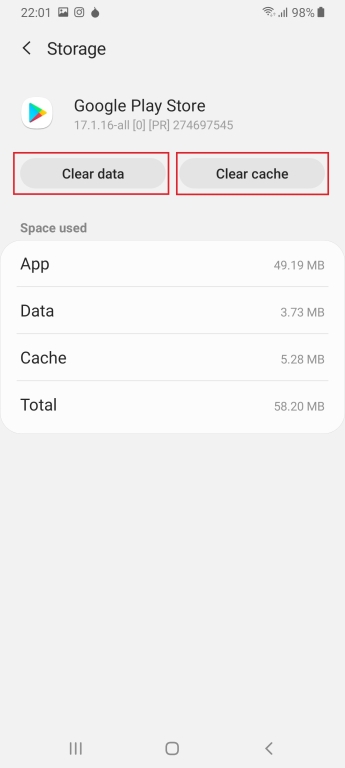

7- Play Store Cache leeren (aktualisiert Apps nicht)

- Öffnen Sie auf dem Gerät die App „Einstellungen„.

- Tippen Sie auf Apps.

- Scrollen Sie nach unten und tippen Sie auf „Google Play Store„.

- Tippen Sie auf Speicher.

- Drücken Sie nun die Schaltfläche „Daten löschen“ und dann „Cache leeren„.

Führen Sie diese Aktion für „Google Play Services“ aus und starten Sie Ihr Telefon neu.

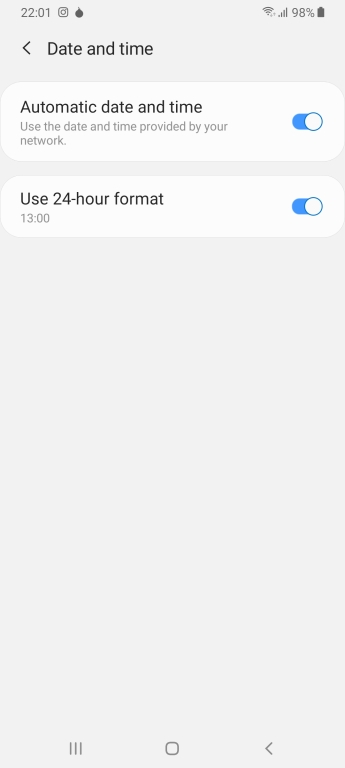

8- Stellen Sie Datum und Uhrzeit auf den automatischen Modus ein

Wenn Sie Datum und Uhrzeit Ihres Telefons nicht richtig eingestellt haben, funktioniert Google Play möglicherweise nicht richtig. Folgen Sie den unteren Schritten:

- Öffnen Sie die (Einstellungen).

- Gehen Sie zur “Allgemeine Geschäftsführung”.

- Scrollen Sie zu „Datum und Uhrzeit„.

- Aktivieren Sie die Option „Automatisches Datum und Uhrzeit„.

Was ist Ihre Meinung zu diesem Text?

Wir hoffen, dass dieses Tutorial für Sie hilfreich ist. Wenn Sie Fragen haben, senden Sie uns einen Kommentar.