Rauschen in der ADSL-Leitung ist eine der häufigsten ADSL-Störungen, mit denen Benutzer konfrontiert sind und verursacht langsames Internet. Es gibt mehrere Gründe, die Ihre Internetgeschwindigkeit verlangsamen. Einer der wichtigsten Gründe ist das Problem in der Telefonleitung, das unterschiedlich sein kann. Leitungsrauschen kann der Hauptfaktor für die Verlangsamung der ADSL-Internetgeschwindigkeit sein. In diesem Text erfahren Sie, wie Sie das ADSL-Rauschproblem lösen und die Qualität der Telefonleitung verbessern, die Geschwindigkeit des Internets erhöhen und verhindern, dass das ADSL-Licht ausgeschaltet wird.

Inhaltsverzeichnis:

Inhaltsverzeichnis:

- Geräuscherkennung Training auf der ADSL-Telefonleitung

- Erfahren Sie, wie das ADSL-Rauschen beheben und die Qualität verbessern

- Überprüfen Sie den Splitter, um das ADSL-Rauschproblem zu beheben

- Aktualisieren der Firmware oder Adsl Modem-Software, um das Rauschproblem zu lösen

- Legen Sie die Netzkabel nicht neben das ADSL-Modem

- Überprüfen Sie die Position des Telefonkabels

- Überprüfen Sie das Rauschen des Telefons (Kratzgeräusch)

- Andere effektive Faktoren für ADSL-Rauschen

Geräuscherkennung Training auf der ADSL-Telefonleitung

Als Erstes müssen Sie überprüfen, ob Ihre Telefonleitung Rauschen aufweist oder nicht. Führen Sie dazu die folgenden Schritte aus.

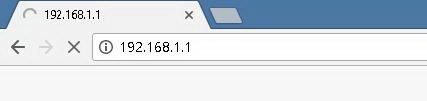

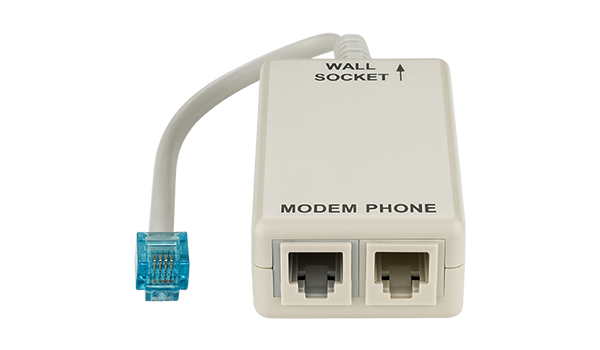

Öffnen Sie den Browser, geben Sie 192.168.1.1 in die Adressleiste ein und drücken Sie die Eingabetaste. Es wird nach Ihrem Benutzernamen und Passwort gefragt, die beide meistens „admin“ normalerweise sind.

Rufen Sie in den Modemeinstellungen (settings) die Seite Status oder Statistik auf und suchen Sie nach „Verbindungsdämpfung“ (Link attenuation) und „SNR“ oder „Rauschen“ (Noise). „Verbindungsdämpfung“ ist ein Indikator für die Signaldämpfung und „SNR“ ist die Menge des Nutzsignals gegen störendes Signal.

Der „SNR“ -Wert wird in Dezibel eingestellt und die größeren Zahlen zeigen die bessere Qualität Ihrer Telefonleitung. Der Standard ist wie folgt.

- 6 dB und weniger = sehr geringe Qualität (ernstes Problem in der Leitung)

- 7dB ~ 10dB = mittel (möglicherweise mit ADSL arbeiten)

- 11 dB ~ 20 dB = normal

- 20 dB ~ 28 dB = ausgezeichnet

- 29 dB und mehr = bestmögliche Bedingungen

Je niedriger der Dämpfungswert (Attenuation) ist, desto weniger Rauschen hat Ihre Telefonleitung und der Standard ist wie folgt.

- 20 dB und weniger = sehr hohe Qualität

- 20 dB ~ 30 dB = ausgezeichnet

- 30 dB ~ 40 dB = Sehr gut

- 40 dB ~ 50 dB = gut

- 50 dB ~ 60 dB = schwach

- 60 dB = Sehr geringe Qualität

Erfahren Sie, wie das ADSL-Rauschen beheben und die Qualität verbessern

Wenn Sie sicher sind, dass Ihre Leitung Rauschen hat, können Sie das Rauschen reduzieren und die Internetgeschwindigkeit mithilfe der folgenden Lösungen erhöhen.

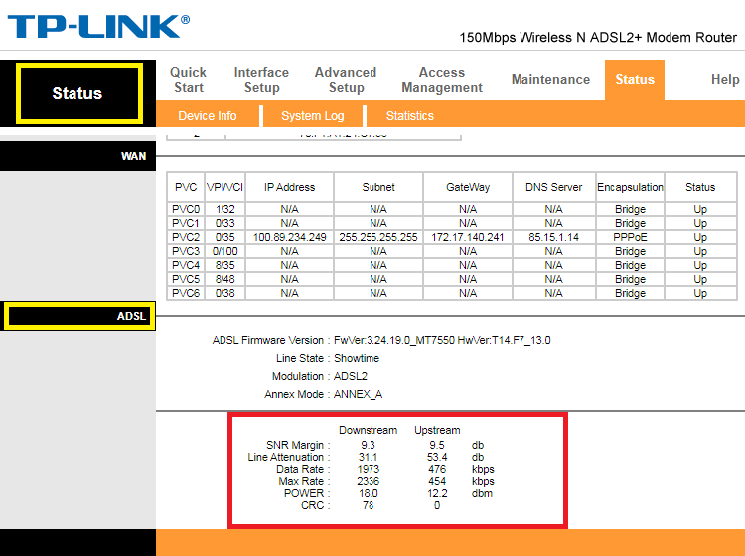

Überprüfen Sie den Splitter, um das ADSL-Rauschproblem zu beheben

Das Geräusch kann auf eine Fehlfunktion oder zerstören des Splitters zurückzuführen sein. Verwenden Sie daher einen neuen Splitter und testen Sie das Geräusch. Dieser Teil spielt eine wichtige Rolle bei der Reduzierung des Rauschens und kann das Problem lösen.

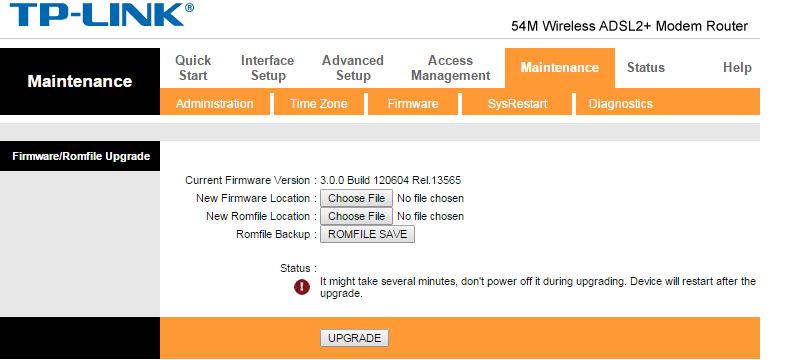

Aktualisieren der Firmware oder Adsl Modem-Software, um das Rauschproblem zu lösen

Da Ihr Modem möglicherweise keine neuen IT-Plattformen unterstützt, wird empfohlen, Ihre Modem-software regelmäßig zu aktualisieren. Versuchen Sie auch, die von Ihrem ISP empfohlenen Modems zu verwenden.

Legen Sie die Netzkabel nicht neben das ADSL-Modem

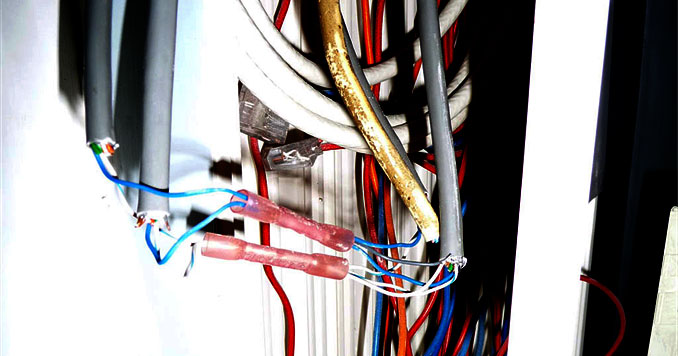

Wenn Sie Stromkabel neben Ihr Modem legen, wird ein Magnetfeld erzeugt, das Rauschen verursacht. Versuchen Sie daher, eine kleine Steckdosenleiste neben dem Modem zu verwenden und diese so weit wie möglich vom Modem und der Telefonleitung entfernt zu halten.

Überprüfen Sie die Position des Telefonkabels

Befindet sich in der Nähe des Telefonkabels ein Aufzug oder eine elektrische Heizung, verursacht dies Geräusche. Es ist auch besser, Kupferdraht mit einer Anti-Rausch-Beschichtung für die Telefonleitung zu verwenden.

Überprüfen Sie das Rauschen des Telefons (Kratzgeräusch)

Wenn Sie ein Kratzgeräusch vom Telefon hören, bedeutet dies, dass Ihre Telefonleitung ein Problem hat. Daher muss die Telefonleitung auf kurze Verbindung überprüft werden. Stellen Sie außerdem sicher, dass sich die Telefonleitung nicht in der Nähe des Hochspannungskabels befindet. Andernfalls müssen Sie ein separates Kabel für das Modem in Betracht ziehen.

Andere effektive Faktoren für ADSL-Rauschen

- Das Vorhandensein eines Virus im System und die Verwendung von Datenverkehr.

- Vorübergehendes Problem aufgrund der Reparatur der Telekommunikationsleitungen.

- Überbeanspruchung des Datenverkehrs durch andere Benutzer im Netzwerk.

Was ist Ihre Meinung zu diesem Text?

Wir hoffen, dass diese Informationen hilfreich für Sie sind. Wenn Sie Fragen haben, senden Sie uns Ihre Kommentare.